Google, Facebook und weitere Cloudanbieter durchsuchen jedes Foto auf deren Servern nach bedenklichen Inhalten. Googles kostenlose Mail-Dienstleistung Gmail durchsucht jedes private E-Mail. All diese Dienste werden weltweit fleissig genutzt.

Apple überprüft mit iOS 15 die Foto-Mediathek lokal auf dem Gerät nach Kinderpornografie. Die Meinungen dazu sind gespalten.

«Sie haben gerade offen zugegeben, dass sie keine Antwort darauf haben, was zu tun ist, wenn China anklopft. Es ist kaum zu unterschätzen, wie katastrophal dieses neue System für die iPhone-Sicherheit ist.»

Apple's new iPhone contraband-scanning system is now a national security issue. They just openly admitted they have no answer for what to do when China comes knocking.

Hard to understate how disastrous this new system is for iPhone security. Tim Cook needs to intervene. https://t.co/eQHSH7KGx4

— Edward Snowden (@Snowden) August 9, 2021

Wie die Suche nach Kinderpornografie vonstattengeht, ist simpel erklärt und bedenkenlos. Apple erklärt im PDF «CSAM Detection» das Vorgehen. Bedenken gibt es meiner Meinung nach dabei, dass Apple solche Durchsuchungen nach Inhalten/Fotos unbemerkt einführen kann und dafür keinen An-/Aus-Schalter anbietet.

Diese Erkennung findet – vereinfacht gesagt – mit einer Prüfsumme statt. Jede Datei und jedes Bild kann in einen mathematischen Fingerabdruck umgewandelt werden. Das Ganze ist eine Einbahnstraße: Der Fingerabdruck lässt beim Vergleich mit einem anderen Fingerabdruck den Rückschluss zu, ob es sich um dasselbe oder ein ähnliches Bild handelt. Die Prüfsumme lässt sich aber nicht in das Bild zurückverwandeln.

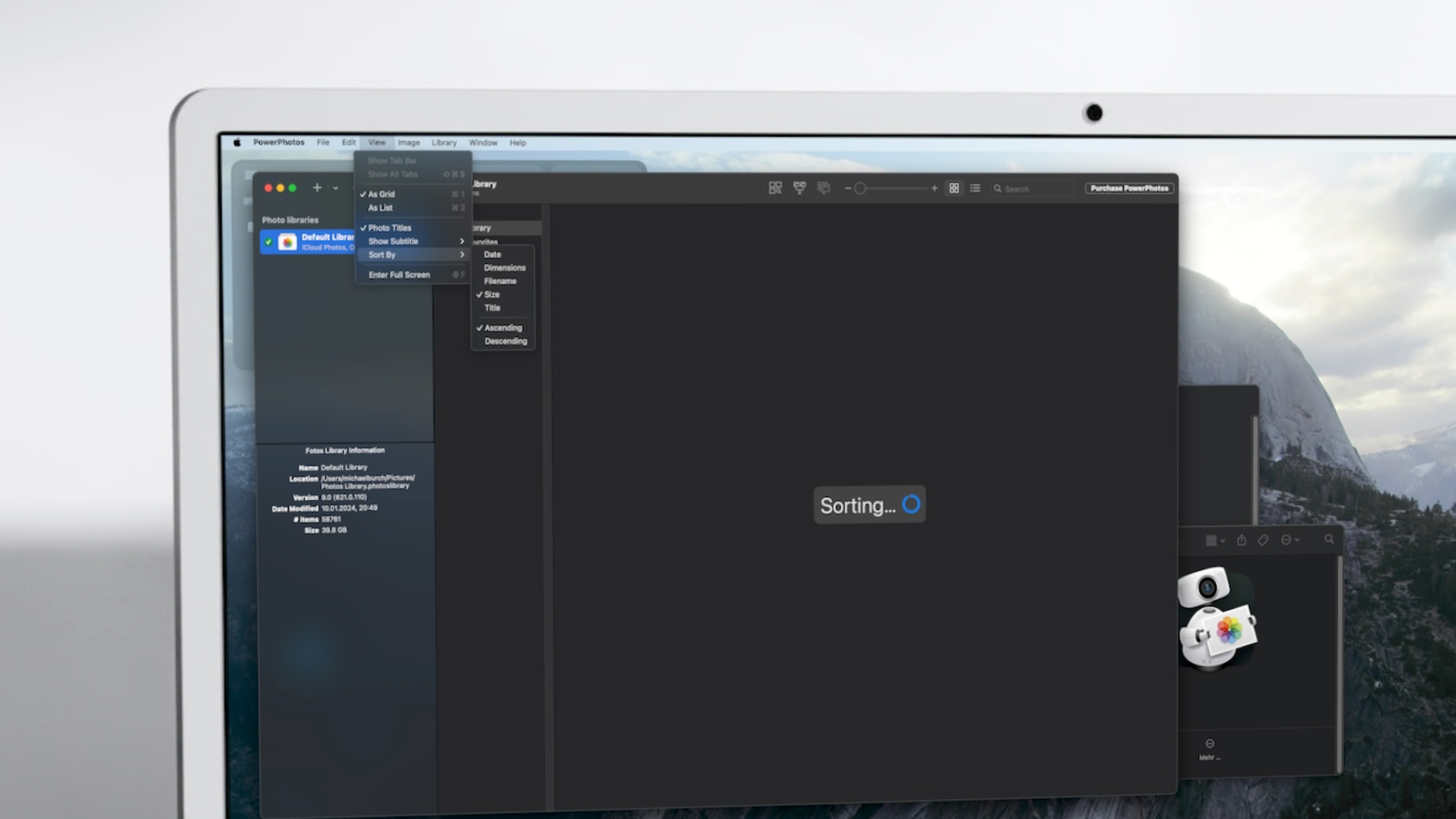

Aktuell ist es so, dass Fotos beim Hochladen in die iCloud, lokal auf dem iPhone nach dem oben beschriebenen verfahren nach Kinderpornografie durchsucht. Voraussetzung dafür iOS 15, iPadOS 15 und iCloud-Fotospeicherung. Deswegen iCloud-Fotos deaktivieren, nein.